Las Vegas, Nevada – 29 de novembro

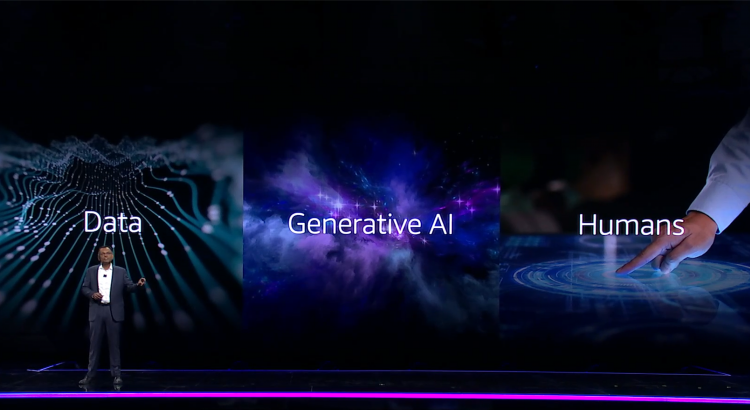

Após estabelecer os indicadores para a nova era de inteligência artificial generativa (GenAI) na última terça-feira, a Amazon Web Services (AWS) revelou os serviços e ferramentas essenciais para materializar essa visão. Em seu discurso de abertura no Re:Invent 2023, Dr. Swami Sivasubramanian, vice-presidente de dados e IA da AWS, apresentou uma metáfora intrigante, comparando a IA generativa a uma “exuberante explosão de energia conhecida como supernova”, para ilustrar o atual cenário da IA no universo tecnológico. Sivasubramanian enfatizou o desenvolvimento de um elo poderoso entre humanos e tecnologia, ao explicar que estamos experienciando o desdobramento de uma relação entre dados, IA generativa e seres humanos.

Amazon SageMaker

Em continuidade, Sivasubramanian sustenta que o sucesso dessa relação está intrinsecamente ligado à capacidade da AWS em oferecer bases sólidas para a implementação de IA generativa para os seus clientes e parceiros. Assumindo essa perspectiva, ele detalhou que esse suporte envolve acesso a foundation models, ambiente privado para exploração de dados, ferramentas intuitivas para a construção e implementação de algoritmos, além de toda infraestrutura para treinamento de modelos customizados disponibilizados de forma fácil e intuitiva..

Essa estrutura dependerá consideravelmente do SageMaker, a plataforma de aprendizado de máquina da empresa da AWS, e do recém-lançado assistente generativo baseado em IA, o Amazon Q. O Amazon Bedrock, serviço totalmente gerenciado pela AWS, para disponibilizar foundation models por meio de APIs, também foi destacado como um recurso de grande importância nessa jornada. Em relação ao SageMaker, a AWS apresentou o HyperPod, uma solução projetada para aliviar a carga indiferenciada e exaustiva associada à otimização da infraestrutura de aprendizado de máquina para o treinamento de modelos. A empresa afirmou que essa nova oferta reduz significativamente o tempo necessário para o treinamento de modelos – chegando a uma diminuição de até 40%.

Sivasubramanian explicou a relevância desse avanço, afirmando que os clientes testemunharão melhorias substanciais. A importância do HyperPod se encontra em sua capacidade de superar as limitações específicas da infraestrutura de tecnologia da informação, especialmente no que diz respeito ao tratamento de grandes volumes de dados e à complexidade envolvida no treinamento de modelo, já que frequentemente isso implicava dividir o processo de treinamento em centenas ou milhares de aceleradores, executando trilhões de cálculos de dados simultaneamente ao longo de semanas ou meses, explicou Sivasubramanian. Além disso, o SageMaker HyperPod possibilita aos clientes automatizar a distribuição das cargas de trabalho de treinamento entre recursos de computação, salvando pontos de verificação periodicamente para evitar perda de tempo em caso de falha em algum componente.

Novos recursos Amazon Redshift

Considerando o anúncio mais importante do Re:Invent 2023, o assistente de inteligência artificial generativa Amazon Q, a AWS incorporou mais uma funcionalidade de SQL generativo no Redshift, para descomplexificar a elaboração de consultas. Foi adicionado um recurso de integração de dados na plataforma serverless AWS Glue, agora também habilitado para operar por meio de linguagem natural. Sivasubramanian destacou que o Amazon Q oferece suporte abrangente a diversas áreas de negócio, conectando-se diretamente aos dados já existentes. Ele descreveu que a IA desempenha um papel categórico na melhoria da base de dados subjacente, fornecendo soluções para desafios importantes na gestão de dados.

O Amazon Bedrock também ganhou destaque. Lançado em setembro, o presidente-executivo da AWS, Adam Selipsky, e Sivasubramanian observaram que mais de 10.000 mil clientes já utilizam o Bedrock. De acordo com os executivos, a empresa continua aprimorando o Bedrock com uma série de atualizações, incluindo recursos de ajuste fino e novos serviços de segurança. O foco atual é atender à demanda por uma variedade mais ampla de modelos, e a AWS revelou a incorporação do Claude 2.1, a versão mais recente do modelo de linguagem da Anthropic, bem como a adição do Llama2 70B da Meta.

Sivasubramanian salientou que estamos nos estágios iniciais da inteligência artificial generativa, e espera-se que esses modelos evoluam rapidamente. Nesse horizonte, o Bedrock emerge como uma ferramenta conveniente no cenário de evolução dos bancos de dados vetoriais, a exemplo do Redis Enterprise Cloud e Pinecone, já adaptados ao Bedrock, e MongoDB e Amazon Aurora planejados para integração em breve. A AWS também anunciou novos recursos de pesquisa vetorial, abrangendo OpenSearch Serverless, Document DB, Dynamo DB e Amazon MemoryDB for Redis.

Família Amazon Titan

Em outro momento da apresentação, Sivasubramanian revelou novos modelos da família Amazon Titan: o Image Generator e Multimodal Embeddings, além de anunciar que os modelos de geração de texto Titan Text Lite e Titan Text Express estão agora disponíveis no Amazon Bedrock.

O maior destaque do anúncio foi o Amazon Titan Image Generator, atualmente em modo de visualização. Este modelo permite que os usuários criem e refinem imagens usando instruções simples, tornando-o uma ferramenta versátil para aplicações em publicidade, comércio eletrônico e projetos de mídia e entretenimento em grande escala. A ferramenta promete gerar imagens realistas com qualidade de estúdio e baixo custo.

Já o Titan Multimodal Embeddings é uma solução para a necessidade de sistemas inteligentes capazes de analisar e compreender informações provenientes de diferentes fontes. Ele permite aos usuários enviar texto, imagem ou uma combinação de ambos como entrada. Essa flexibilidade abre portas para uma gama diversificada de aplicações, desde pesquisas contextuais até recomendações altamente personalizadas. Na prática, a ferramenta tem em sua capacidade converter imagens e textos curtos em inglês, com até 128 tokens, em embeddings. Porém, esses embeddings não são simples representações, mas vetores que capturam o conteúdo, o significado semântico e as relações subjacentes entre os dados.

O Titan Text Lite e o Titan Text Express, por sua vez, representam modelos avançados de linguagem personalizados para abranger uma extensa variedade de tarefas relacionadas à geração de texto. Essas tarefas incluem resumos, traduções, sistemas de chatbot para perguntas e respostas, além de identificar o papel de agentes. Esses modelos também se destacam como assistentes de coordenação, capazes de gerar código com suporte a linguagens de programação como JSON e CSV. O Titan Text Lite é um modelo mais leve, especificamente concebido para tarefas em inglês, com um comprimento máximo de contexto de 4.096 tokens, otimizado para eficiência de custos. Por outro lado, o Titan Text Express possui o dobro da janela de contexto do Lite, com 8.192 tokens, oferecendo uma gama abrangente de recursos. Isso inclui geração de texto aberto, brainstorming, criação de código, reescrita e interações de chatbot.

Fonte: Amazon.com.

Imagens: Amazon Web Services.